La regresión logística es una técnica utilizada para resolver problemas de modelización cuando nuestra variable independiente Y es categórica y representa la ocurrencia de un suceso en particular. Lo más normal y el caso que estudiaremos se refiere a variables independientes dicotómicas, auque si dicha variable presenta más de dos categorías , habría que tomar como objeto la regresión logística multinomial. Hay que decir que a diferencia de otros métodos multivariantes , la regresión logística admite variables dependiente continuas y categóricas. Y como última observación, aunque ya veremos por qué, este método no es más que una particularización de los denominados GLM (modelos lineales generalizados), que relacionan una variable dependiente con la combinación lineal de otras dependientes a través de una función de enlace.

El objetivo pues será modelizar la probabilidad de ocurrencia de un suceso en función de la aparición de una serie de factores. Tal como hemos dicho nuestra variable Y tomará dos valores y presentará pues una distribución de Bernoulli, siendo su función de masa:

de manera que representamos con el valor 1 el éxito con probabilidad p de que ocurra y con 0 el no-éxito con probbabilidad 1-p. La regresión logística tiene por última finalidad la de poner en relación dicha variable dicotómica con otras variables y así poder estimar E[Y/x], es decir hallar el valor de p cuando se dan una serie de factores condicionantes. Además pensad en qué cantidad de problemas y situaciones en la vida real se puden modelizar de esta manera...

Imaginemos un caso práctico. Sabemos que en una determinada población hay una tasa en cierta enfermedad del 0.09%. Pero sabemos que el sobrepeso aumenta mucho el riesgo de padecer la dolencia. Si no disponemos de esta información, no podemos decir nada acerca de la probabilidad de un individuo con sobrepeso. Sin embargo si sabemos que un individuo efectivamente tiene sobrepeso , podremos como mínimo asegurar que tiene un riesgo mayor de padecer la enfermedad. Si tomamos una muestra y vemos que esto es así con una determinada probabilidad , podremos entonces para otra muestra o la población , inferir la probabilidad de un individuo en función de si presenta o no sobrepeso.

Hay numerosas técnicas estadísticas y computacionales para resolver o modelizar este tipo de problemas. Aunque en cada problema siempre hay que considerar distintas alternativas de modelización, a menudo la regresión logística se presenta como uno de los mejores o el emjor método para resolver el problema. Veamos a continuación la formulación de la regresión logística:

o de manera equivalente:

siendo p=E[Y/X=xi].

siendo p=E[Y/X=xi].Obviamente p será la probabilidad de ocurrencia del evento (en nuestro caso el padecer la enfermedad) y las xi serán los factores dependientes, en nuestro ejemplo la observación de sobrepeso.

Bien , ya sabemos que mediante este modelo podemos a partir de cierta información , inferir la probabilidad de que suceda algo, a través de una fórmula un tanto extraña donde el número e (qué raro) y por tanto el Ln aparecen involucradas. Y aunque el ejemplo del sobrepeso y la enfermedad es un tanto ingénuo, la utilidad de estos métodos sale a la luz cuando tenemos muchos factores involucrados y poca información de cómo influyen el la ocurrencia o no de un determinado suceso.

En las próximas entradas sobre el tema veremos qué pinta ahí el número e, qué es la función logística, la transformación logit y qué papel juega en todo esto la familia exponencial. ¿El objetivo? Como siempre, explicar el por qué de las cosas.

Salimos hasta la próxima entrada.

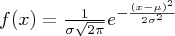

, donde E representa la esperanza matemática e i la unidad imaginaria. La función característica de la distribución normal vendrá de integrar su densidad multiplicada por

, donde E representa la esperanza matemática e i la unidad imaginaria. La función característica de la distribución normal vendrá de integrar su densidad multiplicada por . Esto resulta (no voy a desarrollar el cálculo) en

. Esto resulta (no voy a desarrollar el cálculo) en